Integridad Artificial: la IA más allá del cortoplacismo

¿Es importante la "IA para el bien" y por qué debería interesarnos? El autor de Artificial Integrity: The Paths to Leading AI Toward a Human-Centered Future, Hamilton Mann, ejecutivo tecnológico y pionero de la tecnología digital y la IA para el bien, habla del concepto de integridad artificial, un concepto que trasciende a las directrices éticas de la IA y que elimina las limitaciones e ineficiencias de las actuales barreras de protección de esta tecnología. “La integridad debe convertirse en la estrella polar de cada algoritmo de IA”, afirma.

En esta entrevista realizada por la editora de xBN Isabella Mader en el marco del 16th Global Peter Drucker Forum, Hamilton desgrana minuciosamente las particularidades y beneficios de su metamodelo de integridad artificial y el modo en el que las organizaciones pueden implementar el nuevo marco de trabajo que conlleva.

ISABELLA MADER: En un mundo impulsado por el cortoplacismo, ¿qué importancia tiene la “IA para el bien”?

HAMILTON MANN: La cuestión no es si la "IA para el bien" es importante, sino si podemos permitirnos construir una IA para cualquier otra cosa. Deberíamos ampliar los límites de la IA, sin eludir los notables avances que puede ofrecer a la sociedad y, al mismo tiempo, sin rehuir tampoco la responsabilidad igualmente grande que nos impone. Esta última es inseparable de la primera. El entusiasmo y la prisa por la IA no son excusa ni tolerancia para la irresponsabilidad; sino todo lo contrario.

Confiar en la IA solo tiene sentido si el sistema se construye garantizando su buen rendimiento y guiándose, en primer lugar, por la integridad, especialmente en los resultados que pueden cambiar la vida con más frecuencia de lo que creemos.La "IA para el bien" es la responsabilidad de diseñar una IA que eleve a la humanidad, no que la disminuya

La "IA para el bien" es la responsabilidad de diseñar una IA que eleve a la humanidad, no que la disminuya. Se trata de algo más que crear algo nuevo, moderno o de moda; se trata de crear algo que sea seguro y sostenible considerando todas las implicaciones que esta tecnología tiene en la sociedad.

La "IA para el bien" es la responsabilidad de diseñar una IA que eleve a la humanidad, no que la disminuya. Se trata de algo más que crear algo nuevo, moderno o de moda; se trata de crear algo que sea seguro y sostenible considerando todas las implicaciones que esta tecnología tiene en la sociedad.

Si permitimos que el pensamiento a corto plazo nos guíe en esa construcción, terminaremos con tecnologías de IA que resuelven los problemas equivocados o ninguno en el mejor de los casos o que crean y agravan otros, la mayoría de las veces. El desarrollo de la IA debe centrarse en lo que realmente importa, no solo en lo que es conveniente. Al inventar el coche, no pretendíamos fabricar el carruaje más rápido; al aprovechar y utilizar la electricidad, no pretendíamos hacer la lámpara de aceite más grande. El pensamiento inexplorado de quienes nos llevaron a lograr algunas de las invenciones más transformadoras que han cambiado positivamente la sociedad debería servir como testimonio de cómo construimos la IA. Teniendo en cuenta estas inspiraciones, debemos aprovechar tanto los beneficios que ha conllevado como las lecciones de lo que ha tenido implicaciones negativas para la sociedad, para desarrollar la IA en el marco de una nueva definición de lo que significa verdaderamente el progreso para nuestro tiempo, pero sobre todo para la próxima generación.El mundo no recuerda a quienes persiguen lo inmediato, sino a quienes redefinen lo posible

La IA debería amplificar el potencial humano, y no servir únicamente a los beneficios trimestrales o a la última tendencia. Sabemos que el cortoplacismo es tentador. Es más fácil optimizar los clics o las ganancias rápidas. Pero el mundo no recuerda a quienes persiguen lo inmediato, sino a quienes redefinen lo posible. La "IA para el bien" importa porque persigue dejar el mundo mejor de lo que lo encontramos. No tiene por qué ser relevante para todas y cada una de las personas: el hecho de que pueda ser importante para unas pocas es una condición necesaria y suficiente para que se produzca un cambio significativo. La justificación empresarial y social de esto no radica en ganancias temporales o a corto plazo, sino en un "retorno de la inversión" duradero que todos buscaremos cada vez más (como clientes, usuarios y ciudadanos) dondequiera que estemos, cualesquiera que sean nuestras diferencias, preferencias, necesidades diarias o limitaciones: integridad artificial por encima de inteligencia artificial.

I.M.: La integridad suele ser una 'gran desaparecida'. ¿Cree que la economía actual la recompensa o se la pasa por alto?

H.M.: La economía actual no la recompensa, pero excluye para siempre a las empresas por su falta. En ese sentido, tenerla no siempre es una ventaja adicional, aunque esto está evolucionando. Sin embargo, es una condición necesaria para perdurar y eso hace que sea una cualidad que ninguna empresa debería pasar por alto. Las empresas llevan mucho tiempo reconociendo que la reputación de la marca y la lealtad del cliente dependen de una prueba social basada en la integridad inquebrantable como imperativo de vida o muerte. La historia de los negocios está repleta de ejemplos de faltas de integridad que llevaron a empresas "tipo Aquiles" al colapso, como Enron, Lehman Brothers, WorldCom, Arthur Andersen y, más recientemente, WeWork, Theranos y FTX. A medida que las empresas integran la IA en sus operaciones, muchas pasan por alto un factor crítico: la integridad de los resultados de sus sistemas de IA

No obstante, a medida que las compañías integran la IA en sus operaciones, desde el servicio al cliente hasta el marketing y la toma de decisiones, todas las miradas se centran en la promesa de aumentar la productividad y la eficiencia, y muchas pasan por alto un factor crítico: la integridad de los resultados de sus sistemas de IA.

No obstante, a medida que las compañías integran la IA en sus operaciones, desde el servicio al cliente hasta el marketing y la toma de decisiones, todas las miradas se centran en la promesa de aumentar la productividad y la eficiencia, y muchas pasan por alto un factor crítico: la integridad de los resultados de sus sistemas de IA.

¿Qué podría ser más irresponsable? Sin ella, las empresas se enfrentan a riesgos considerables, desde el escrutinio regulatorio a las repercusiones legales, pasando por la erosión de la reputación de la marca y el posible colapso. La regla en los negocios siempre ha sido el rendimiento, pero el rendimiento logrado a costa de un comportamiento amoral no es rentable ni sostenible. Como dijo Warren Buffett: “Cuando necesites contratar personas, buscas tres cualidades: integridad, inteligencia y energía. Pero si no tienen la primera, las otras dos te matarán”.

Al "contratar" IA para dirigir sus operaciones o para ofrecer valor a sus clientes, los líderes deben asegurarse de que no esté operando sin control en cuanto a la integridad por el bien de la reputación, los valores y el valor de la empresa. La urgencia de una supervisión de la integridad artificial para guiar a la IA en las empresas es todo menos artificial.

I.M.: ¿En qué se diferencia la integridad artificial de la ética de la IA?

H.M.: La integridad artificial va más allá de las pautas éticas de la IA. Representa una cualidad autorreguladora incorporada en el propio sistema de IA. La integridad artificial consiste en insertar principios éticos en el diseño de la IA para guiar su funcionamiento y resultados, de forma muy similar a cómo la integridad humana guía el comportamiento y el impacto incluso sin supervisión externa, para movilizar la inteligencia en favor del bien. Cubre el vacío crítico que las pautas éticas por sí solas no pueden abordar al permitir varios cambios importantes:La integridad artificial va más allá de las pautas éticas de la IA. Representa una cualidad autorreguladora incorporada en el propio sistema de IA

De los insumos a los resultados:

- Las directrices éticas de la IA suelen ser reglas, códigos o marcos establecidos por entidades externas, como gobiernos, organizaciones u organismos de supervisión. A menudo se imponen a los sistemas de IA desde el exterior como una entrada (insumo), y exigen su cumplimiento sin ser parte integral del funcionamiento básico del sistema.

- La integridad artificial es una cualidad inherente y autorreguladora incorporada en el propio sistema de IA. En lugar de limitarse a seguir reglas impuestas externamente, una IA con integridad “comprende” e incorpora automáticamente principios éticos en sus procesos de toma de decisiones. Esta brújula interna garantiza que la IA actúe en consonancia con los valores éticos, incluso cuando la supervisión externa sea mínima o inexistente, maximizando la entrega de resultados basados en la integridad.

Del cumplimiento al funcionamiento básico:

- Las pautas éticas de la IA se centran en el cumplimiento y la adhesión. Los sistemas de IA pueden cumplir estas directrices siguiendo una lista de verificación o realizando determinadas acciones cuando se les solicite. Sin embargo, este cumplimiento suele ser reactivo y superficial, y requiere supervisión y cumplimiento.

- La integridad artificial es una función básica incorporada en la IA. Opera de manera proactiva y continua, guiando las decisiones en función de principios éticos sin necesidad de recurrir a un reglamento. Es similar a cómo la integridad humana guía a alguien a hacer lo correcto incluso cuando nadie está mirando.La integridad artificial opera de manera similar a la humana, guiando a hacer lo correcto incluso cuando nadie está mirando

De las posturas fijas a la sensibilidad contextual:

- Las pautas éticas de la IA suelen ser rígidas y pueden tener dificultades para tener en cuenta situaciones con matices o que cambian rápidamente. Por lo general, están diseñadas para una amplia aplicabilidad y es posible que no se adapten bien a todos los contextos con los que se encuentra un sistema de IA.

- La integridad artificial es adaptable y sensible al contexto, lo que permite que la IA aplique un razonamiento ético de forma dinámica en situaciones en tiempo real. Una IA con integridad sopesaría las implicaciones éticas de las diferentes opciones en el contexto, tomando decisiones que se ajusten a los valores fundamentales en lugar de aplicar rígidamente normas que tal vez no aborden por completo la complejidad de la situación.

De una toma de decisiones reactiva a una proactiva:

- Las pautas éticas de la IA suelen aplicarse de forma reactiva, después de que se identifica un posible problema o una infracción ética. Se utilizan para corregir un comportamiento o evitar errores repetidos. Sin embargo, cuando estas pautas entran en vigor, es posible que ya se haya producido un daño.

- La integridad artificial opera de manera proactiva, evaluando los posibles riesgos y dilemas éticos antes de que surjan. En lugar de limitarse a evitar acciones punibles, una IA con integridad busca alinear cada decisión con los principios éticos desde el principio, minimizando la probabilidad de resultados perjudiciales.Funciona de manera proactiva, evaluando los posibles riesgos y dilemas éticos antes de que surja

De la observancia a la autonomía:

- Las pautas éticas de la IA requieren mecanismos de cumplimiento, como auditorías, regulaciones o sanciones, para garantizar que los sistemas de IA las respeten. La IA no prioriza inherentemente estas reglas.

- La integridad artificial hace cumplir sus normas éticas de manera autónoma. No requiere de vigilancia externa, porque sus consideraciones éticas son intrínsecas a su arquitectura de toma de decisiones. Este tipo de sistema, por ejemplo, se negaría a actuar ante órdenes que violaran principios éticos fundamentales, incluso sin intervención humana explícita.No requiere de vigilancia externa, porque sus consideraciones éticas son intrínsecas a su arquitectura de toma de decisiones

I.M.: ¿Hasta qué punto la integridad artificial mejoraría las ineficiencias de los actuales guardarraíles de la IA?

H.M.: Estos mecanismos, aunque fundamentales, presentan limitaciones. Las actuales barreras de protección o guardarraíles, como los filtros de contenido, los optimizadores de resultados, los orquestadores de procesos y las capas de gobernanza, tienen como objetivo identificar, corregir y gestionar los problemas en los resultados de la IA, garantizando al mismo tiempo el cumplimiento de los estándares éticos.

Los filtros de contenido detectan lenguaje ofensivo, tendencioso o dañino, pero a menudo se basan en reglas estáticas y predefinidas que no se adaptan a contextos complejos o cambiantes.

Los optimizadores de resultados corrigen los errores identificados por los filtros y refinan las respuestas generadas por IA, pero su naturaleza reactiva limita su capacidad de anticiparse a los problemas antes de que surjan. Los orquestadores de procesos coordinan las interacciones iterativas entre filtros y optimizadores, lo que garantiza que los resultados cumplan con los umbrales, pero estos sistemas consumen muchos recursos y son propensos a ofrecer resultados subóptimos si se limitan las correcciones.

Los optimizadores de resultados corrigen los errores identificados por los filtros y refinan las respuestas generadas por IA, pero su naturaleza reactiva limita su capacidad de anticiparse a los problemas antes de que surjan. Los orquestadores de procesos coordinan las interacciones iterativas entre filtros y optimizadores, lo que garantiza que los resultados cumplan con los umbrales, pero estos sistemas consumen muchos recursos y son propensos a ofrecer resultados subóptimos si se limitan las correcciones.

Las capas de gobernanza proporcionan supervisión y registro, lo que permite la rendición de cuentas, pero dependen en gran medida de marcos éticos iniciales, que pueden ser rígidos y propensos a sesgos, en particular en escenarios imprevistos.

A pesar de sus contribuciones, estas barreras de protección exponen lagunas críticas en la misión más amplia de crear sistemas de IA éticos. Su diseño reactivo significa que abordan los problemas solo después de que ocurren, en lugar de prevenirlos. Carecen de la conciencia contextual necesaria para abordar la ética matizada o situacional, lo que a menudo conduce a resultados que son éticamente sólidos de forma aislada, pero problemáticos en su contexto. Dependen en gran medida de estándares estáticos definidos por humanos, lo que corre el riesgo de perpetuar sesgos sistémicos en lugar de cuestionarlos o corregirlos. Además, sus procesos iterativos son intensivos en términos computacionales, lo que genera inquietudes sobre la ineficiencia energética y la escalabilidad en aplicaciones del mundo real. Las limitaciones de estos mecanismos apuntan a la necesidad de un nuevo paradigma que incorpore el razonamiento basado en la integridad en el núcleo de los sistemas de IA.Al incorporar estas salvaguardas en la lógica central de la IA, la integridad artificial elimina las ineficiencias de los procesos iterativos de protección, ofreciendo resultados éticamente sólidos y eficientes en términos de recursos en tiempo real

La integridad artificial representa este cambio al ir más allá de las restricciones basadas en reglas o barreras o las restricciones estáticas de las pautas éticas, para convertirse en sistemas capaces de un razonamiento ético proactivo, conciencia contextual y adaptación dinámica a las normas sociales en evolución.

A diferencia de los sistemas de IA existentes, la integridad artificial permite que la IA anticipe dilemas éticos y adapte sus resultados para alinearlos con los valores humanos, incluso en situaciones complejas o imprevistas. Al centrarse en la comprensión contextual, los sistemas de IA con integridad artificial pueden tomar decisiones matizadas que equilibren las consideraciones éticas con los objetivos operativos, evitando los inconvenientes de los modelos de cumplimiento rígidos.

La integridad también aborda el problema generalizado del sesgo al permitir que los sistemas se autoevalúen y refinen sus marcos éticos basándose en el aprendizaje continuo. Esta adaptabilidad garantiza que los sistemas de IA se mantengan alineados con las diversas necesidades de los usuarios y las expectativas sociales, en lugar de reforzar las desigualdades preexistentes.

Al incorporar estas salvaguardas en la lógica central de la IA, la integridad artificial elimina las ineficiencias de los procesos iterativos de protección, ofreciendo resultados éticamente sólidos y eficientes en términos de recursos en tiempo real. La transición de las pautas y barreras éticas de la IA a la Integridad Artificial es una nueva frontera de la IA que incluye la Ética de la IA, pero va más allá, permitiendo que los sistemas de IA imiten la inteligencia ética, social y moral.

I.M.: Su metamodelo de integridad artificial ofrece un nuevo marco de trabajo. ¿Cómo pueden implementarlo las organizaciones en la práctica?

H.M.: Para abordar sistemáticamente los retos de la integridad artificial, las organizaciones pueden adoptar un marco estructurado en torno a tres pilares: el Modelo de Valores de la Sociedad, el Modelo Base de IA y el Modelo de Cointeligencia Humana e IA. Cada uno de estos pilares se refuerza entre sí y se centra en diferentes aspectos de la integridad, desde la concepción de la IA hasta su aplicación en el mundo real.

El Modelo de Valores de la Sociedad gira en torno a los valores fundamentales y los estándares basados en la integridad que se espera que defienda un sistema de IA. Este modelo exige que las organizaciones comiencen a considerar hacer lo siguiente:

- Definir claramente los principios de integridad que se alinean con los derechos humanos, los valores sociales y las regulaciones específicas del sector para garantizar que el funcionamiento de la IA sea siempre responsable, justo y sostenible.

- Considerar los impactos sociales más amplios, como el consumo de energía y la sostenibilidad ambiental, garantizando que los sistemas de IA se diseñen para funcionar de manera eficiente y con una huella ambiental mínima, manteniendo al mismo tiempo los estándares basados en la integridad.

- Incrustar estos valores en el diseño de la IA, incorporando principios de integridad en los objetivos de la IA y la lógica de toma de decisiones, garantizando que el sistema refleje y defienda estos valores en todas sus operaciones, a la par que optimiza su comportamiento al priorizar la alineación de valores sobre el rendimiento.

- Integrar mecanismos autónomos de auditoría y autocontrol directamente en el sistema de IA, lo que permite la evaluación en tiempo real ante normas basadas en la integridad y la generación automática de informes transparentes a los que las partes interesadas pueden acceder para evaluar el cumplimiento, la integridad y la sostenibilidad.

Se trata de construir la perspectiva “exterior” de los sistemas de IA.

El Modelo Central de IA aborda el diseño de mecanismos integrados que garanticen la seguridad, la explicabilidad y la transparencia, manteniendo la rendición de cuentas de los sistemas y mejorando su capacidad de protección contra el uso indebido a lo largo del tiempo. Los componentes clave pueden incluir:

- Implantar marcos sólidos de gobernanza de datos que no solo garanticen la calidad de los mismos, sino que también mitiguen activamente los sesgos y aseguren la equidad en todas las fases de capacitación y operación del sistema de IA,

- Diseñar modelos de IA explicables e interpretables que permitan a las partes interesadas, tanto técnicas como no, comprender el proceso de toma de decisiones de la IA, aumentando la confianza y la transparencia.

- Establecer mecanismos de seguridad integrados que impidan activamente el uso nocivo o indebido, como la generación de contenido inseguro, decisiones poco éticas o la amplificación de sesgos. Estos mecanismos deberían funcionar de forma autónoma, detectando riesgos potenciales y bloqueando resultados perjudiciales en tiempo real.

- Crear marcos de aprendizaje adaptativos donde la IA se vuelva a entrenar y actualizar periódicamente para adaptarse a nuevos datos, abordar los problemas de integridad emergentes y corregir continuamente cualquier sesgo o error con respecto al modelo de valor que pueda ocurrir con el tiempo.

Se trata de construir la perspectiva “interna” de los sistemas de IA.

El Modelo de Cointeligencia Humana e IA enfatiza la relación simbiótica entre los seres humanos y la IA, destacando la necesidad de que los sistemas de IA funcionen considerando el equilibrio entre el “valor añadido humano” y el “valor añadido de IA”, donde la sinergia entre humanos y tecnología redefine el diseño central de nuestra sociedad, preservando a la vez la integridad social.

I.M.: ¿Cómo funcionarían los sistemas de IA que contemplan ese equilibrio entre humanos y tecnología?

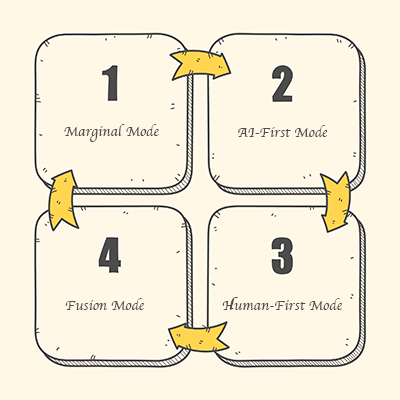

H.M.: Podrían funcionar considerando cuatro modos operativos distintos. El primero es el “Modo Marginal”. En el contexto de la integridad artificial, el modo marginal se refiere a situaciones en las que ni la intervención humana ni la intervención de la IA aportan un valor significativo. Se trata de tareas o procesos que se han vuelto obsoletos, excesivamente rutinarios o ineficientes hasta el punto de que ya no contribuyen de manera positiva a los objetivos de una organización o de la sociedad. En este modo, la prioridad no es utilizar la IA para mejorar las capacidades humanas, sino identificar áreas en las que tanto la intervención humana como la de la IA se han vuelto inútiles.

Una de las funciones clave de la integridad artificial en el modo marginal es la detección proactiva de señales que indican cuándo un proceso o una tarea ya no contribuyen a la organización.Una de las funciones clave de la integridad artificial en el modo marginal es la detección proactiva de señales que indican cuándo un proceso o una tarea ya no contribuyen a la organización

Por ejemplo, si la carga de trabajo de un sistema de soporte al cliente disminuye drásticamente debido a la automatización o a opciones mejoradas de autoservicio, la IA podría reconocer la disminución de la necesidad de participación humana en esa área, ayudando a la organización a tomar medidas para preparar a la fuerza laboral para un trabajo más orientado al valor.

Después está el “Modo IA-First”. En este caso, la fuerza de la IA para procesar grandes cantidades de datos con rapidez y precisión tiene prioridad sobre la contribución humana. La integridad artificial garantizaría que, incluso en estos procesos dominados por la IA, se integren estándares basados en la integridad, como la equidad y el contexto cultural. La integridad artificial garantiza que los sistemas de IA estén diseñados para complementar el juicio humano sin anularlo

Cuando prevalezca la integridad artificial, un sistema de IA que analice los datos de los pacientes para identificar tendencias de salud podría explicar cómo llega a sus conclusiones (por ejemplo, una recomendación para la detección precoz del cáncer), garantizando la transparencia. El sistema también estaría diseñado para evitar sesgos, por ejemplo, asegurando que el modelo tenga en cuenta poblaciones diversas y que las conclusiones extraídas de un grupo demográfico predominante no conduzcan a un asesoramiento médico sesgado o poco fiable.

A continuación estaría el modo que prioriza al ser humano, el “Human-First Mode”. Este prioriza la inteligencia emocional y cognitiva humana, con la IA desempeñando una papel de apoyo para ayudar a las personas a tomar decisiones. La integridad artificial garantiza que los sistemas de IA estén diseñados para complementar el juicio humano sin anularlo, protegiendo a los humanos de cualquier forma de interferencia con el funcionamiento saludable de su cognición, como evitar influencias que exploten las vulnerabilidades del sistema de recompensa de nuestro cerebro, lo que puede llevara a una adicción.

A continuación estaría el modo que prioriza al ser humano, el “Human-First Mode”. Este prioriza la inteligencia emocional y cognitiva humana, con la IA desempeñando una papel de apoyo para ayudar a las personas a tomar decisiones. La integridad artificial garantiza que los sistemas de IA estén diseñados para complementar el juicio humano sin anularlo, protegiendo a los humanos de cualquier forma de interferencia con el funcionamiento saludable de su cognición, como evitar influencias que exploten las vulnerabilidades del sistema de recompensa de nuestro cerebro, lo que puede llevara a una adicción.

En el ámbito jurídico, la IA puede ayudar a los jueces analizando la jurisprudencia anterior, pero no debería sustituir el razonamiento moral y ético de un juez. El sistema de IA debería garantizar la explicabilidad, mostrando cómo llegó a sus conclusiones, respetando el contexto cultural y los valores que se aplican de forma diferente en las distintas regiones o sistemas jurídicos, y garantizando, al mismo tiempo que la acción humana no se vea comprometida en relación con las decisiones que se toman. Este tipo de integraciones avanzadas entre humanos y máquinas requerirán la integridad artificial en su nivel más alto de madurez

Finalmente tenemos el “Modo Fusión”, donde la integridad artificial implica una sinergia entre la inteligencia humana y las capacidades de la IA, combinando lo mejor de ambos mundos. En los vehículos autónomos que funcionan en modo de fusión, la IA gestionaría las operaciones del vehículo, como la velocidad, la navegación y la evitación de obstáculos, mientras que la supervisión humana, potencialmente a través de tecnologías emergentes como las interfaces cerebro-computadora (BCI), ofrecería información en tiempo real sobre dilemas éticos complejos. Por ejemplo, en situaciones de choque inevitables, una BCI podría permitir la comunicación directa entre el cerebro humano y la IA, lo que haría que la toma de decisiones éticas se produjese en tiempo real, combinando la precisión de la IA con el razonamiento moral humano. Este tipo de integraciones avanzadas entre humanos y máquinas requerirán la integridad artificial en su nivel más alto de madurez. La integridad artificial garantizaría no solo la excelencia técnica, sino también la solidez ética, moral y social, protegiendo contra una posible explotación o manipulación de los datos neuronales y dando prioridad a la preservación de la seguridad, la autonomía y la capacidad de acción de los seres humanos.

Los sistemas de integridad artificial serían capaces de actuar en cada modo, a la par que pasarían de uno a otro en función de la situación, la necesidad y el contexto en el que operen. Teniendo en cuenta el modo marginal (donde se requiere una contribución limitada de la IA y de la inteligencia humana; piense en ello como “menos es más”), el modo IA-First (donde la IA tiene prioridad sobre la inteligencia humana), el modo Human-First (donde la inteligencia humana tiene prioridad sobre la IA) y el modo de fusión (donde se requiere una sinergia entre la inteligencia humana y la IA), Modelo de Cointeligencia Humana e IA garantiza que:

- La supervisión humana sigue siendo fundamental en todos los procesos críticos de toma de decisiones, y la IA sirve para complementar la inteligencia humana en lugar de reemplazarla, especialmente en áreas donde el juicio ético y la responsabilidad son primordiales.

- El uso de IA promueve un comportamiento responsable e íntegro, garantizando que su implementación esté en consonancia con los valores organizacionales y sociales, fomentando un entorno donde los sistemas de IA contribuyan positivamente sin causar daño.

- El uso de la IA establece circuitos de retroalimentación continuos entre las percepciones humanas y el aprendizaje de la IA, donde ambas se informan mutuamente sobre el desarrollo. La retroalimentación humana mejora la inteligencia impulsada por la integridad de la IA, mientras que las percepciones basadas en datos de la IA ayudan a refinar la toma de decisiones humana, lo que conduce a una mejora recíproca del desempeño y de los resultados impulsados por la integridad.

Reforzado por el funcionamiento cohesivo de los dos modelos anteriores, el de Cointeligencia Humana e IA refleja las relaciones “inter”, las dependencias, la mediación y la conectividad entre humanos y sistemas de IA. Se trata de construir sistemas de IA que no solo sean inteligentes, sino que también comprendan las implicaciones más amplias de sus acciones

Este es el objetivo de la integridad artificial. Los sistemas diseñados con este propósito encarnarán la integridad artificial, haciendo hincapié en la alineación de la IA con los valores centrados en el ser humano. Esto requiere un enfoque holístico para el desarrollo y la implementación de la IA, que tenga en cuenta no solo las capacidades de la IA sino también su impacto en los valores humanos y sociales. Se trata de construir sistemas de IA que no solo sean inteligentes, sino que también comprendan las implicaciones más amplias de sus acciones.

I.M.: En su libro, habla del concepto “Economic AIquity” (AI+Equity). ¿A qué se refiere?

H.M.: Defino la “equidad económica en inteligencia artificial” como la búsqueda de justicia y equidad en las aplicaciones de inteligencia artificial, garantizando que los sistemas de IA no perpetúen ni exacerben las desigualdades sociales. Este término subraya la importancia de diseñar e implementar tecnologías de IA que sean inclusivas y justas, y que promuevan la igualdad de oportunidades y de trato para todas los individuos.

H.M.: Defino la “equidad económica en inteligencia artificial” como la búsqueda de justicia y equidad en las aplicaciones de inteligencia artificial, garantizando que los sistemas de IA no perpetúen ni exacerben las desigualdades sociales. Este término subraya la importancia de diseñar e implementar tecnologías de IA que sean inclusivas y justas, y que promuevan la igualdad de oportunidades y de trato para todas los individuos.

Algunas noticias recientes han puesto de relieve las preocupaciones sobre la equidad económica de la IA. Una demanda colectiva presentada el 14 de noviembre de 2023 en el Tribunal de Distrito de EE.UU. en Minnesota alega que UnitedHealth Group y sus subsidiarias, UnitedHealthcare y Navihealth, utilizaron tecnología de IA "en lugar de profesionales médicos reales para negar injustamente atención a pacientes de edad avanzada". La demanda afirma que las empresas eran conscientes de que el modelo de IA tenía una tasa de error del 90% en la evaluación de las reclamaciones y había anulado las decisiones tomadas por los médicos de los pacientes, lo que plantea graves problemas éticos y de equidad económica en la atención médica.La “equidad económica en inteligencia artificial” busca justicia y equidad en las aplicaciones de IA, garantizando que los sistemas no perpetúen ni exacerben las desigualdades sociales

Otro ejemplo reciente proviene del Reino Unido, donde se ha descubierto que un sistema de inteligencia artificial utilizado por el gobierno para detectar fraudes en la asistencia social presenta sesgos basados en factores como la edad, la discapacidad, el estado civil y la nacionalidad, según una investigacion de The Guardian. Una evaluación interna del programa de aprendizaje automático, que evalúa miles de solicitudes de crédito universal en toda Inglaterra, reveló que señalaba de forma desproporcionada a personas de ciertos grupos para su investigación, lo que genera inquietudes sobre la equidad y la discriminación.

Considerando las implicaciones multifactoriales que tiene la IA en la sociedad, la dimensión de equidad económica de la IA debe evaluarse y equilibrarse bien, no como una ocurrencia de último momento sino como un reto de diseño fundamental para las aplicaciones de IA que pretendemos implantar en la sociedad.

I.M.:¿Qué consejo ofrecería a los líderes empresariales y a los responsables de las políticas para promover una IA basada en la integridad?

H.M.: No es un consejo, sino más bien una llamada al liderazgo: ya no basta con crear sistemas que calculen valor; debemos crear sistemas que comprendan valores. La integridad debe convertirse en la estrella polar de cada algoritmo de IA, un requisito fundamental que garantice que las tecnologías de IA no solo nos sirvan, sino que nos sirvan bien, y que no solo lo hagan bien, sino que hagan lo correcto.La verdadera preparación para el liderazgo debe garantizar que las máquinas no solo trabajen con nosotros, sino que trabajen para nosotros, alineándose con nuestros ideales más elevados

Lo que de verdad importa es la integridad artificial por encima de la inteligencia artificial, ya que ninguna cantidad de esta última sustituirá jamás la necesidad de la primera. De ahora en adelante, la verdadera preparación para el liderazgo debe garantizar que las máquinas no solo trabajen con nosotros, sino que trabajen para nosotros, alineándose con nuestros ideales más elevados.

Contenido relacionado:

Integridad artificial, la nueva frontera de la IA

Esta entrevista fue realizada por la editora de xBN Isabella Mader en el 16th Global Peter Drucker de noviembre de 2024, y se publicó originalmente en inglés en dicho medio. Isabella Mader es también CEO de Excellence Research y Executive Advisor del Global Peter Drucker Forum.

La entrevista se publica en español en 2025 con la autorización de Hamilton Mann.

Imágenes recurso: © starline y rawpixel.com en Freepik / Fotos de interior de Hamilton Mann: © druckerforum.org