IA con integridad incorporada

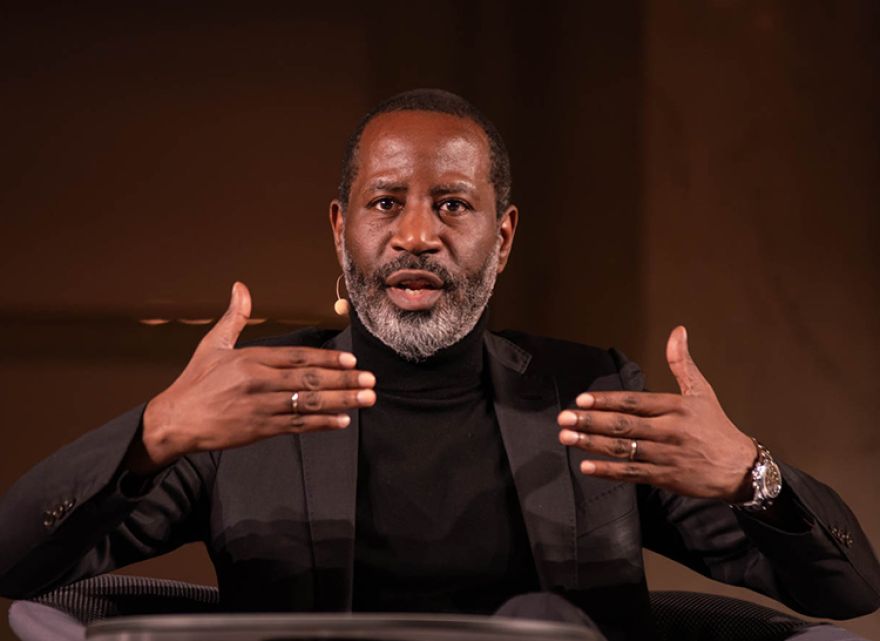

Entrevista con el líder de pensamiento, Hamilton Mann, por Karen Christensen, Editor-in-Chief de Rotman Management. The Magazine of the Rotman School of Management*

PREGUNTA: ¿Cómo describe lo que considera la próxima frontera de la inteligencia artificial (IA)?

HAMILTON MANN: El término Frontier AI (IA de frontera) se suele usar para referirse a modelos de IA que están a la vanguardia de los avances tecnológicos, capaces de realizar una amplia gama de tareas. Los modelos de frontera están sentando las bases de lo que casi podría ser una IA de propósito general (GPAI, por sus siglas en inglés), una meta buscada por una corriente de pensamiento dentro del campo de la IA.

Sin embargo, cuando hablo de la próxima frontera de la IA, paso de centrarme en los avances impulsados por la inteligencia a centrarme en el progreso guiado por la integridad.

Cuando hablo de la próxima frontera de la IA, paso de centrarme en los avances impulsados por la inteligencia a centrarme en el progreso guiado por la integridad

La “Integridad Artificial” representa esta nueva dirección. Propongo que la próxima evolución significativa de la IA sea su capacidad para operar con integridad incorporada. Esto implica diseñar sistemas de IA con un marco inherente que garantice un comportamiento responsable e íntegro de forma sistemática. Esto incluye incorporar principios que permitan a la IA razonar y actuar con valores alineados con la equidad, la inclusión y los estándares éticos. Mientras que los modelos de IA de frontera actuales se centran en ampliar la destreza técnica y la utilidad, a menudo lo hacen a expensas de la responsabilidad, la fiabilidad y, peor aún, de las consideraciones humanas. La integridad artificial abre camino a una IA que pueda ser respetada y confiable, sentando las bases de un futuro donde sus capacidades estén verdaderamente alineadas con las normas, necesidades y obligaciones humanas hacia otros seres.La integridad artificial abre el camino a una IA que pueda ser respetada y confiable

La “Integridad Artificial” representa esta nueva dirección. Propongo que la próxima evolución significativa de la IA sea su capacidad para operar con integridad incorporada. Esto implica diseñar sistemas de IA con un marco inherente que garantice un comportamiento responsable e íntegro de forma sistemática. Esto incluye incorporar principios que permitan a la IA razonar y actuar con valores alineados con la equidad, la inclusión y los estándares éticos. Mientras que los modelos de IA de frontera actuales se centran en ampliar la destreza técnica y la utilidad, a menudo lo hacen a expensas de la responsabilidad, la fiabilidad y, peor aún, de las consideraciones humanas. La integridad artificial abre camino a una IA que pueda ser respetada y confiable, sentando las bases de un futuro donde sus capacidades estén verdaderamente alineadas con las normas, necesidades y obligaciones humanas hacia otros seres.La integridad artificial abre el camino a una IA que pueda ser respetada y confiable

P: ¿Cómo se comporta una IA que es a la vez inteligente e íntegra?

H.M.: Para que los sistemas de IA sean capaces de mantener una integridad artificial, deben incorporar consideraciones éticas como aspecto central de su razonamiento.

Por ejemplo, en el caso de la contratación y el reclutamiento. Si se basan exclusivamente en datos sin tener en cuenta la equidad e inclusión, las herramientas de contratación impulsadas por IA corren el riesgo de replicar sesgos. Los sistemas con integridad artificial abordarían de forma proactiva los posibles sesgos y evaluarían la equidad de los resultados, haciendo recomendaciones inclusivas y justas que respetasen la diversidad y la igualdad de oportunidades.

Para que los sistemas de IA sean capaces de mantener una integridad artificial, deben incorporar consideraciones éticas como aspecto central de su razonamiento

En cuanto a las recomendaciones de productos y la protección al consumidor, los sistemas de IA de comercio electrónico a menudo promueven productos en función de los márgenes de beneficio o los perfiles de usuario, lo que puede llevar a que se ofrezcan productos innecesarios o perjudiciales para los clientes vulnerables. Los sistemas de integridad artificial evaluarían la idoneidad y ética de los productos recomendados, evitando la manipulación y considerando el bienestar del consumidor, especialmente en el caso de los grupos demográficos más vulnerables.

En relación a un abastecimiento ético y sostenible de la cadena de suministro, los sistemas de IA pueden optimizar los costes pero pasar por alto las preocupaciones éticas en torno al origen de los materiales, las prácticas laborales y el impacto medioambiental. Los sistemas con integridad artificial darían prioridad a proveedores que cumplan con estándares laborales éticos y criterios de sostenibilidad ambiental, aunque no sean la opción más barata.

El hecho es que la inteligencia por sí sola, sin un marco moral que la guíe, puede desviarse fácilmente de su curso, arriesgándose a consecuencias imprevistas.

P: ¿Cuáles son algunos de los primeros pasos necesarios para crear este tipo de inteligencias artificiales?

H.M.: Un elemento esencial en la construcción de un modelo de IA de este tipo radica en el proceso de datos. Más allá del etiquetado, que generalmente se refiere al proceso de identificar y asignar una categoría predefinida a un dato, es necesario adoptar la práctica de anotar los conjuntos de datos de manera sistemática. Mientras que el etiquetado de datos asigna una forma de identificación para que el sistema los reconozca, la anotación permite añadir información más detallada y extensa. La anotación de datos confiere al dato una forma de significado abstracto, de modo que el sistema pueda contextualizar la información de algún modo. Mientras que el etiquetado de datos asigna una forma de identificación para que el sistema los reconozca, la anotación permite añadir información más detallada y extensa. Es necesario adoptar la práctica de anotar los conjuntos de datos de manera sistemática

H.M.: Un elemento esencial en la construcción de un modelo de IA de este tipo radica en el proceso de datos. Más allá del etiquetado, que generalmente se refiere al proceso de identificar y asignar una categoría predefinida a un dato, es necesario adoptar la práctica de anotar los conjuntos de datos de manera sistemática. Mientras que el etiquetado de datos asigna una forma de identificación para que el sistema los reconozca, la anotación permite añadir información más detallada y extensa. La anotación de datos confiere al dato una forma de significado abstracto, de modo que el sistema pueda contextualizar la información de algún modo. Mientras que el etiquetado de datos asigna una forma de identificación para que el sistema los reconozca, la anotación permite añadir información más detallada y extensa. Es necesario adoptar la práctica de anotar los conjuntos de datos de manera sistemática

El objetivo sería incluir anotaciones que caractericen un “código de integridad” que refleje valores, juicios íntegros sobre esos valores, principios que los sustentan o resultados que deben considerarse inapropiados. Por ejemplo, en un conjunto de datos utilizado para entrenar un chatbot de atención al cliente, las anotaciones podrían incluir evaluaciones sobre integridad con respecto al modelo de valores de referencia, asegurando que las respuestas del chatbot se basen en la cortesía, el respeto y la equidad. Los datos de entrenamiento también podrían incluir anotaciones sobre la toma de decisiones éticas en escenarios críticos o garantizar que los datos se utilicen éticamente, respetando la privacidad y el consentimiento.

Otro elemento esencial para que un modelo de IA sea capaz de mostrar características de integridad artificial radica en los métodos de entrenamiento. Una IA entrenada mediante “técnicas de aprendizaje supervisado” que permitan al modelo aprender no solo a realizar una tarea sino también a reconocer resultados preferibles guiados por la integridad, es un camino prometedor para el desarrollo de la integridad artificial. El objetivo sería incluir anotaciones que caractericen un código de integridad que refleje valores, juicios íntegros sobre esos valores, principios que los sustentan o resultados que deben considerarse inapropiados

También es razonable añadir información sobre el modelo de valores utilizado para entrenar un determinado modelo de IA mediante anotaciones de datos, y luego usar aprendizaje supervisado para ayudar a la IA a entender qué encaja o no en ese modelo de valores. Por ejemplo, respecto a los modelos de IA que pueden usarse para crear deepfakes, la capacidad de ayudar al sistema a comprender que ciertos usos indican falsificaciones profundas y no se ajustan al modelo de valores demostraría la integridad artificial.

P: ¿Cuáles son algunos de los desafíos clave a los que se enfrenta el desarrollo de modelos de integridad artificial?

H.M.: Una de las principales dificultades es la subjetividad de los valores: diferentes culturas, comunidades e individuos pueden tener perspectivas variadas sobre lo que constituye un comportamiento ético. Además, la escalabilidad plantea otro reto. La anotación de grandes conjuntos de datos con códigos de integridad detallados requiere recursos significativos, tanto de tiempo como de experiencia humana, y puede que no siempre sea factible la práctica. Este proceso puede complicarse aún más por el riesgo de introducción de sesgos: los propios anotadores pueden, sin querer, incorporar sus propios prejuicios en el sistema de IA, dando lugar a resultados distorsionados o discriminatorios.La anotación de grandes conjuntos de datos con códigos de integridad detallados requiere recursos significativos, tanto de tiempo como de experiencia humana

Para superar estos problemas, es fundamental que los sistemas de IA se diseñen con mecanismos de aprendizaje y adaptación continuos. Los modelos de IA dotados de integridad artificial deben evolucionar a la par que cambian las normas éticas y los valores sociales, lo que puede lograrse mediante bucles de retroalimentación humana continua y actualizaciones dinámicas de los datos anotados. Esto permitiría al sistema recalibrar sus decisiones a medida que cambian los contextos culturales o las normas éticas. Los modelos de IA dotados de integridad artificial deben evolucionar a la par que cambian las normas éticas y los valores sociales, lo que puede lograrse mediante bucles de retroalimentación humana continua y actualizaciones dinámicas de los datos anotados

P.: Usted cree que desarrollar IA con integridad requiere colaboración interdisciplinaria. ¿Por qué es tan importante?

H.M.: Es una obligación, no un “bonito detalle”. La integridad artificial es inalcanzable si los desarrolladores de IA trabajan de forma aislada. Eticistas, sociólogos, responsables de políticas públicas, expertos en la materia, grupos diversos de usuarios y otros profesionales deben participar desde el inicio para asegurar un enfoque global que refleje una variedad de perspectivas. En general, se trata de un tema que requiere más investigadores comprometidos con construir una IA que defienda los valores humanos más allá de la búsqueda del rendimiento por el rendimiento. Yo soy uno de ellos. La integridad artificial requiere más investigadores comprometidos con construir una IA que defienda los valores humanos más allá de la búsqueda del rendimiento por el rendimiento. Yo soy uno de ellos

H.M.: Es una obligación, no un “bonito detalle”. La integridad artificial es inalcanzable si los desarrolladores de IA trabajan de forma aislada. Eticistas, sociólogos, responsables de políticas públicas, expertos en la materia, grupos diversos de usuarios y otros profesionales deben participar desde el inicio para asegurar un enfoque global que refleje una variedad de perspectivas. En general, se trata de un tema que requiere más investigadores comprometidos con construir una IA que defienda los valores humanos más allá de la búsqueda del rendimiento por el rendimiento. Yo soy uno de ellos. La integridad artificial requiere más investigadores comprometidos con construir una IA que defienda los valores humanos más allá de la búsqueda del rendimiento por el rendimiento. Yo soy uno de ellos

P.: Muchos tienen esperanza en que la IA pueda ayudar en la lucha contra el cambio climático. Sin embargo, también presenta su propio impacto ambiental. ¿Puede describir el estado actual de esta paradoja?

H.M.: Por un lado, la IA tiene un potencial increíble para ayudar a combatir el cambio climático optimizando el uso de energía, mejorando los modelos climáticos, fomentando prácticas sostenibles y permitiendo una gestión más inteligente de los recursos. Por ejemplo, puede utilizarse para predecir el consumo energético, desarrollar sistemas de transporte más eficientes y apoyar soluciones innovadoras en energías renovables.

Por otro lado, también debemos reconocer que la tecnología no es inherentemente sostenible ni está libre de efectos sociales negativos. La potencia de cálculo necesaria para entrenar modelos de IA a gran escala puede ser inmensa, consumiendo enormes cantidades de energía y generando significativas emisiones de carbono. La producción y el mantenimiento de la infraestructura física que sustenta la IA, como los centros de datos, incrementan aún más este impacto ambiental, creando una “deuda ambiental”. No existe tecnología sin deuda ambiental. Cada componente de la infraestructura digital conlleva una huella ecológica que debe reconocerse, medirse y tenerse en cuenta en un enfoque de desarrollo tecnológico sostenible

La realidad es que no existe tecnología sin deuda ambiental. Cada componente de la infraestructura digital, desde el algoritmo más pequeño hasta el sistema de IA más potente, conlleva una huella ecológica. Esta deuda debe reconocerse, medirse y tenerse en cuenta en nuestro enfoque de desarrollo tecnológico sostenible.

La esperanza no radica solo en aprovechar la IA para obtener beneficios medioambientales, sino en hacerlo de manera consciente, integrando prácticas ecológicas en todo el ciclo de vida de los sistemas de IA, desde el diseño y desarrollo hasta el despliegue y la operación.

El futuro de la IA en la lucha contra el cambio climático debe implicar un enfoque dual: aprovechar sus capacidades para lograr un impacto positivo y mitigar activamente su huella ambiental. Esto significa priorizar algoritmos energéticamente eficientes, invertir en centros de datos alimentados con energías renovables e integrar la sostenibilidad como un principio central en el desarrollo de la IA.

P.: Ha creado un marco para la cointeligencia humano-IA. ¿En qué consiste?

H.M.: Para abordar los retos de alcanzar la integridad artificial, aconsejo a las organizaciones que adopten un marco estructurado en torno a tres pilares: el Modelo de Valor Social, el Modelo de IA y el Modelo de Co-Inteligencia Humano–IA. Cada pilar refuerza al otro y se enfoca en diferentes aspectos de la integridad.

El Modelo de Valor Social se centra en la integración de normas y valores fundamentales de integridad en los sistemas de IA para garantizar operaciones responsables y sostenibles. Se espera que las organizaciones definan unos principios claros de integridad alineados con los derechos humanos, los valores sociales y las regulaciones pertinentes; que integren estos principios en el diseño y en la toma de decisiones de la IA para reflejarlos y mantenerlos a lo largo de las operaciones del sistema; que tengan en cuenta impactos sociales más amplios, como el consumo de energía para lograr eficiencia sostenible; y que implementen auditorías continuas y mecanismos transparentes de rendición de cuentas para monitorear regularmente el cumplimiento, la integridad y la sostenibilidad. Este modelo trata de construir la perspectiva “externa” de los sistemas de IA.El Modelo de Valor Social se centra en la integración de normas y valores fundamentales de integridad en los sistemas de IA para garantizar operaciones responsables y sostenibles

El Modelo de IA se enfoca en incluir mecanismos que prioricen la seguridad, la explicabilidad y la transparencia, asegurando la responsabilidad del sistema y previniendo el uso indebido. Entre los elementos esenciales figuran la aplicación de una gobernanza sólida de datos para mantener la calidad de los mismos, reducir los sesgos y promover la equidad; el diseño de modelos explicables e interpretables que mejoren la comprensión y confianza de las partes interesadas; la incorporación de mecanismos autónomos que detecten y eviten resultados perjudiciales o sesgados en tiempo real; y la creación de marcos de aprendizaje adaptativo que permitan continuas actualizaciones y reentrenamientos para corregir los sesgos y adaptarse a la evolución de los problemas de integridad. Además, el modelo de IA debe estar arraigado en cualidades de integridad a través de sus datos de entrenamiento y el desarrollo de algoritmos, garantizando que los estándares y principios éticos estén incorporados desde el inicio. El Modelo de IA se enfoca en incluir mecanismos que prioricen la seguridad, la explicabilidad y la transparencia, asegurando la responsabilidad del sistema y previniendo el uso indebidoEste desarrollo debería capacitar a la IA para detectar patrones que infrinjan normas morales y éticas, permitiendo la prevención proactiva de comportamientos no éticos y reforzando la toma de decisiones responsable. Este modelo trata de construir la perspectiva “interna” de los sistemas de IA.

Por último, el Modelo de Co-Inteligencia Humana e IA enfatiza la relación colaborativa entre ambos, abarcando varios modos: Modo Marginal (contribución limitada de IA, con la inteligencia humana a la cabeza); Modo Primero IA o AI-First (donde la IA tiene prioridad); Modo Primero Humano o Human-First (en el que la inteligencia humana tiene primacía); y Modo Fusión (una sinergia equilibrada entre la inteligencia humana y la IA). Este modelo asegura que la supervisión humana siga siendo fundamental en todas las decisiones críticas, y que la IA complemente y no sustitya al juicio humano, particularmente donde la ética y la responsabilidad son cruciales. Reforzado por el funcionamiento cohesivo de los dos modelos anteriores, el Modelo de Co-Inteligencia Humana y de la IA refleja la interrelación y conexión entre los humanos y los sistemas de IA.

Por último, el Modelo de Co-Inteligencia Humana e IA enfatiza la relación colaborativa entre ambos, abarcando varios modos: Modo Marginal (contribución limitada de IA, con la inteligencia humana a la cabeza); Modo Primero IA o AI-First (donde la IA tiene prioridad); Modo Primero Humano o Human-First (en el que la inteligencia humana tiene primacía); y Modo Fusión (una sinergia equilibrada entre la inteligencia humana y la IA). Este modelo asegura que la supervisión humana siga siendo fundamental en todas las decisiones críticas, y que la IA complemente y no sustitya al juicio humano, particularmente donde la ética y la responsabilidad son cruciales. Reforzado por el funcionamiento cohesivo de los dos modelos anteriores, el Modelo de Co-Inteligencia Humana y de la IA refleja la interrelación y conexión entre los humanos y los sistemas de IA.

P.: ¿Podría exponer con más detalle estos cuatro modos operativos del Modelo de Co-Inteligencia?

H.M.: En el contexto de la integridad artificial, el Modo Marginal se refiere a situaciones en las que ni la participación humana ni la de la IA aporta un valor significativo. Son tareas o procesos que se han vuelto obsoletos, excesivamente rutinarios o ineficientes hasta el punto de que ya no contribuyen positivamente a los objetivos de una organización o de la sociedad. En este modo, la prioridad no es usar la IA para mejorar las capacidades humanas, sino identificar áreas donde tanto la intervención humana como la de la IA se han vuelto inútiles.

Uno de los roles clave de la integridad artificial en el Modo Marginal es la detección proactiva de señales que indiquen cuándo un proceso o tarea ya no aporta a la organización. Por ejemplo, si la carga de trabajo de un sistema de atención al cliente disminuye drásticamente debido a la automatización o a opciones de autoservicio mejoradas, la IA podría reconocer la necesidad decreciente de participación humana en esa área, ayudando a la organización a tomar medidas para preparar a la fuerza laboral para tareas orientadas a la generación de más valor. Uno de los roles clave de la integridad artificial en el Modo Marginal es la detección proactiva de señales que indiquen cuándo un proceso o tarea ya no aporta a la organización

En el caso del segundo modo, AI-First, la fortaleza de la IA para procesar grandes cantidades de datos con velocidad y precisión tiene prioridad sobre la contribución humana. La integridad artificial garantizaría que incluso en estos procesos dominados por la IA, se integren estándares guiados por la integridad como la equidad y el contexto cultural.

En el caso del segundo modo, AI-First, la fortaleza de la IA para procesar grandes cantidades de datos con velocidad y precisión tiene prioridad sobre la contribución humana. La integridad artificial garantizaría que incluso en estos procesos dominados por la IA, se integren estándares guiados por la integridad como la equidad y el contexto cultural.

En un mundo donde prevaleciese la integridad artificial, un sistema de IA que analizase datos de pacientes para identificar tendencias de salud podría explicar cómo llega a sus conclusiones (por ejemplo, a una recomendación para una detección precoz de cáncer), garantizando la transparencia.

El sistema también estaría diseñado para evitar sesgos; por ejemplo, asegurando que el modelo tenga en cuenta poblaciones diversas, garantizando que las conclusiones extraídas de un grupo demográfico predominante no conduzcan a consejos médicos sesgados o poco confiables.

La tercera modalidad es Human-First. Esta prioriza la inteligencia cognitiva y emocional humana, con la IA desempeñando un papel de apoyo para asistir en la toma de decisiones humanas. La integridad artificial garantiza que los sistemas de IA aquí estén diseñados para complementar el juicio humano sin reemplazarlo, protegiendo a los humanos de cualquier forma de interferencia con el funcionamiento saludable de su cognición, como evitar influencias que exploten vulnerabilidades en el sistema de recompensa de nuestro cerebro, lo cual puede llevar a la adicción.

La tercera modalidad es Human-First. Esta prioriza la inteligencia cognitiva y emocional humana, con la IA desempeñando un papel de apoyo para asistir en la toma de decisiones humanas. La integridad artificial garantiza que los sistemas de IA aquí estén diseñados para complementar el juicio humano sin reemplazarlo, protegiendo a los humanos de cualquier forma de interferencia con el funcionamiento saludable de su cognición, como evitar influencias que exploten vulnerabilidades en el sistema de recompensa de nuestro cerebro, lo cual puede llevar a la adicción.

Por ejemplo, en entornos legales, la IA puede asistir a los jueces analizando jurisprudencia previa, pero no debe reemplazar el razonamiento moral y ético de un juez. El sistema de IA debería asegurar explicabilidad mostrando cómo llegó a sus conclusiones mientras se adhiere al contexto cultural y valores que aplican de manera diferente según las regiones o sistemas legales, asegurando que la agencia humana no se vea comprometida con respecto a las decisiones que se tomen. El Modo de Fusión, que implica una sinergia entre la inteligencia humana y las capacidades de la IA, combinando lo mejor de ambos mundos

La cuarta modalidad es el Modo de Fusión, que implica una sinergia entre la inteligencia humana y las capacidades de la IA, combinando lo mejor de ambos mundos. En un escenario donde los vehículos autónomos operasen en Modo de Fusión, la IA manejaría las operaciones del vehículo –como velocidad, navegación y evasión de obstáculos–, mientras la supervisión humana, potencialmente a través de tecnologías emergentes como interfaces cerebro-ordenador (BCI), ofrecería información en tiempo real sobre dilemas éticos complejos.

Por ejemplo, en situaciones de colisión inevitable, un BCI podría permitir la comunicación directa entre el cerebro humano y la IA, posibilitando que la toma de decisiones éticas ocurra en tiempo real, combinando la precisión de la IA con el razonamiento moral humano. Este tipo de integraciones avanzadas requerirán una integridad artificial en su más alto nivel de madurez, asegurando no solo excelencia técnica, sino también solidez ética. Lo ideal sería que los sistemas fueran capaces de funcionar en cada modo, pasando de uno a otro según la situación, la necesidad y el contexto en el que operen. Este es el objetivo final de la integridad artificial. Lo ideal sería que los sistemas fueran capaces de funcionar en cada modo, pasando de uno a otro según la situación, la necesidad y el contexto en el que operen. Este es el objetivo final de la integridad artificial

P.: ¿Estamos preparados, personal y profesionalmente, para los cambios que la IA traerá a la sociedad?

H.M.: Aunque se han logrado muchos avances en la adopción y aprovechamiento de la IA en todos los sectores, la realidad es que gran parte de la sociedad todavía está poniéndose al día con el rápido ritmo del cambio tecnológico. Para afrontarlo de manera efectiva, la preparación debe convertirse en una responsabilidad compartida que abarque a individuos, comunidades, organizaciones y gobiernos.

A nivel personal, prepararse para el impacto de la IA significa adoptar una mentalidad de adaptabilidad y aprendizaje continuo. La integración de la IA en nuestra vida diaria y en el trabajo nos desafía a mejorar nuestras habilidades, desarrollar la alfabetización digital y cultivar habilidades de pensamiento crítico que nos permitan trabajar junto a sistemas inteligentes, en lugar de ser reemplazados por ellos. Esta preparación no se trata solo de habilidades técnicas, sino también de comprender las implicaciones éticas, sociales y psicológicas de la IA y cómo afectan nuestro rol como individuos de la sociedad.La integración de la IA en nuestra vida diaria y en el trabajo nos desafía a mejorar nuestras habilidades, desarrollar la alfabetización digital y cultivar habilidades de pensamiento crítico que nos permitan trabajar junto a sistemas inteligentes, en lugar de ser reemplazados por ellos

Desde una perspectiva profesional, las organizaciones necesitan reimaginar sus estrategias de fuerza laboral, priorizando no solo la adopción tecnológica sino también políticas centradas en el ser humano que tengan en cuenta el bienestar y desarrollo de los empleados. Estos han de tener acceso a formación y sistemas de apoyo que los empoderen para usar la IA de manera responsable y efectiva. Esta preparación se extiende a la adopción de la ética de la IA, asegurando que el desarrollo de IA en su organización se alinee con valores como la equidad, la transparencia y la rendición de cuentas.

Prepararse para los cambios que deparará la IA no es un esfuerzo individual; es una responsabilidad colectiva. Gobiernos, empresas, educadores y tecnólogos deben colaborar para construir infraestructuras que apoyen el acceso equitativo a los beneficios de la IA, al mismo tiempo que mitigan riesgos como la pérdida de empleos, las preocupaciones vinculadas con la privacidad y el aumento de las desigualdades. Si la sociedad asume la responsabilidad de prepararse para el impacto de la IA, personal y profesionalmente, podemos crear una base que respalde la resiliencia y la innovación, asegurando que los beneficios de la IA sean amplios y equilibrados.

*Esta entrevista fue realizada por la editora jefe de Rotman Management Magazine, Karen Christensen, para el número de Primavera de dicha publicación, donde se publicó originalmente en inglés.

La entrevista se publica en español con la autorización de Hamilton Mann, a quien agradecemos la cortesía, así como a Rotman Management. The Magazine of the Rotman School of Management. University of Toronto.

Hamilton Mann es Vicepresidente del Grupo de Marketing Digital y Transformación Digital en Thales y autor de Artificial Integrity: The Paths to Leading AI to a Human-Centered Future (Wiley, 2024). También es profesor invitado en INSEAD y profesor titular en HEC París y EDHEC Business School. Además, es mentor en el MIT Priscilla King Gray (PKG) Center y anfitrión de The Hamilton Mann Conversation.

Fotografías de Hamilton Mann: © druckerforum.org / Imágenes recurso: © Pikisuperstar y Kipargeter en Freepik.

Publicado en mayo de 2025.